OpenAI發表全新AI模型GPT-5.3-Codex-Spark,專為快速寫程式而設。Codex-Spark在Cerebras的晶片上運行,每秒可生成超過1,000個token,令開發者在寫程式時能夠近乎即時收到回應,明顯比正式一般版Codex或對手Claude Code快。目前以研究預覽形式向ChatGPT Pro用戶開放。

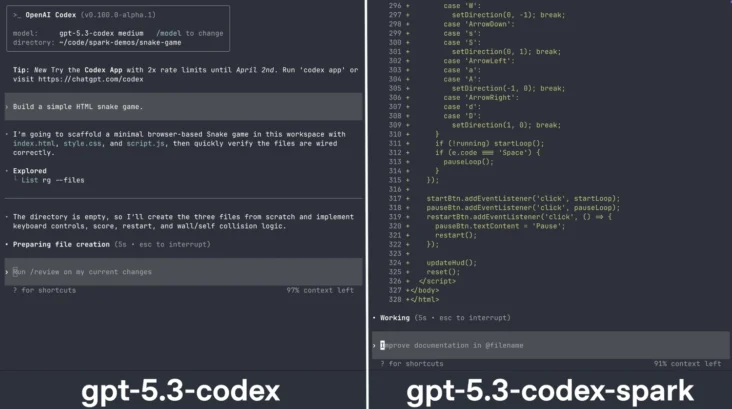

Codex-Spark是GPT-5.3-Codex的縮小版本,定位與一般版Codex不同。完整版Codex擅長處理需時數小時甚至數日的長時間自動任務,而Codex-Spark則專注於即時合作,適合快速修改程式碼、調整邏輯或改善介面等需要即時反饋的工作。OpenAI表示,Codex由此同時支援長時間任務和即時互動兩種模式。

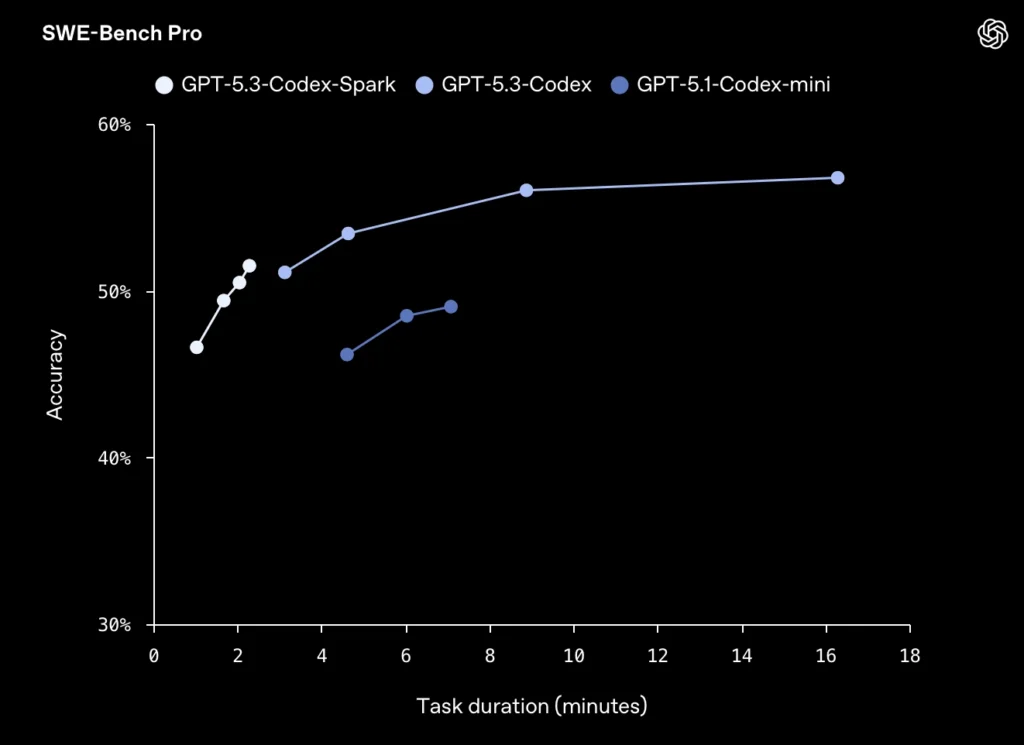

在寫程式能力測試方面,Codex-Spark雖然準確度略低於完整版Codex,但完成任務所需時間大幅縮短。在SWE-Bench Pro測試中,完整版Codex準確度約六成,Codex-Spark則約五成,不過任務完成時間僅為完整版的數分之一。

為配合Codex-Spark的即時需求,OpenAI重新改寫了底層的數據傳輸架構。透過引入持續連接的WebSocket通道,伺服器與客戶端之間每次來回的延遲減少八成,每個token的傳輸大小減少三成,首個token的回應時間亦減半。

Codex-Spark在Cerebras的第三代晶圓級運算引擎上運行。Cerebras聯合創辦人兼技術總監Sean Lie表示,與OpenAI等合作發掘AI快速推理帶來的新可能,是他們最期待的一環。OpenAI強調,GPU仍然是訓練和推理的基礎,Cerebras則在需要極低延遲的工作流程中發揮補充作用,兩者可以在同一工作中結合使用。

Codex-Spark目前可處理的文字量上限為128k token,僅支援文字輸入。OpenAI計劃日後推出更大型號、更長處理容量及支援加入多媒體的版本。未來Codex的兩種模式亦會結合,可在即時互動的同時,將較長時間的任務分派給其他後台處理,甚至同時調動多個模型並行運作。